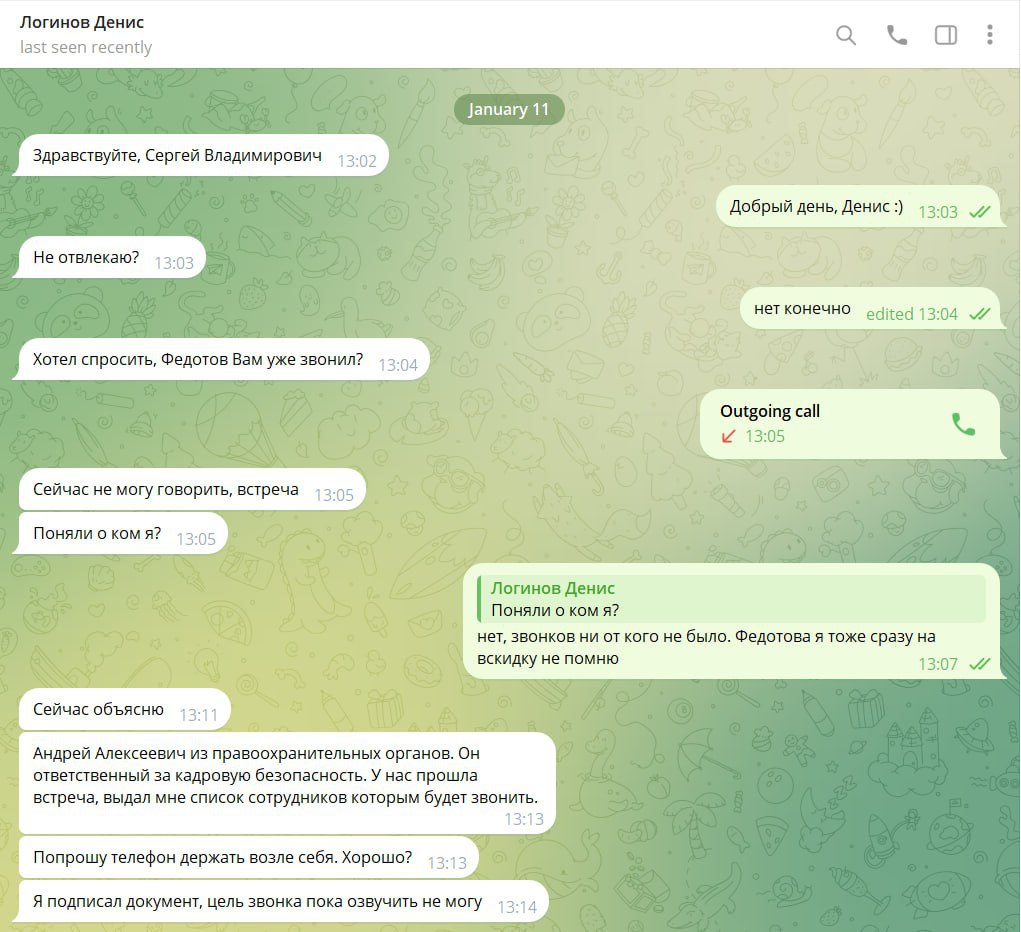

На неделе я и мои знакомые коллеги — владельцы и директора ИТ-компаний — столкнулись с новым видом интернет-криминала. К нашим сотрудникам в региональных филиалах на связь вышли якобы руководители с персональными аватарками. Аккаунты были привязаны к другим телефонным номерам. Но кто знает, сколько их у начальника?

Руководитель-бот в спокойной, но строгой, отеческой манере в ходе переписки в мессенджере поведал, что компания допустила нарушение закона одним из сотрудников (произошла утечка данных, кража денег — в данном случае это не столь важно). В связи с этим в ближайшее время сотрудникам позвонят некие важные люди из органов, которым необходимо оказать содействие. Понятно, что этот спектакль (см. скриншот) нужен, чтобы втереться в доверие. И далее — реализовать уже известную схему типа перевода денег на безопасный счет или какую-то более изощренную.

Проблема в том, что злоумышленник, подкованный в нейролингвистическим программировании (НЛП), вооружившись технологиями, подменяющими личность, становится практически невидимым и стопроцентно успешным. Тем паче, что близость технологий кражи на доверии и больших языковых моделей так называемого генеративного (общего) ИИ кажется мне очевидной.

В психологии применяется НЛП, в программировании — Natural Language Processing (NLP — обработка естественного языка, — прим. ред.). Это не одно и тоже, но схожесть названий отражает общие задачи по изучению языковых структур. Возможности перекрестного использования НЛП и NLP огромны. Практика в этой области развивается стремительно. Увы, быстрее всего — криминальная.

К счастью, наши сотрудники быстро заподозрили неладное: связались с руководством, и мошенников оперативно отшили. Примечательный, на мой взгляд, факт: злоумышленники изначально нацелились на людей возрастом от 45 лет. То есть рассматривали в роли потенциальных жертв тех, кто не является представителем поколения цифровых «аборигенов» —родившихся в семьях, где у родителей уже были компьютер или смартфон. Такие с раннего детства научились общаться с помощью гаджетов, и злоумышленникам сложнее их провести.

Но лиха беда начало! С ИИ-инструментами у кибермошенников появляется гораздо больше шансов облапошить даже самых продвинутых пользователей. С развитием генеративного ИИ подмены станут все более незаметными.

Недаром российские власти активизировали работу по регулированию цифровых технологий подмены личности. Уже в этом году за дипфейки могут ввести наказание.

В декабре прошлого года премьер Михаил Мишустин дал поручение Минцифры проработать к 19 марта вопрос выявления фейков, созданных с помощью ИИ. Глава думского ИТ-комитета Александр Хинштейн заявил в январе, что в России может быть введена ответственность за незаконное использование чужого голоса и изображения. А на неделе правительственная комиссия под председательством начальника МВД Владимира Колокольцева поручила Минцифры с Роскомнадзором дать соответствующие предложения к 1 ноября.

Мошенничества, подлоги и дезинформация с применением общего искусственного интеллекта представляют большую угрозу для любого государства и общества.

Увы, вал дипфейков нарастает по всему миру, и бороться с этим обязательно нужно. Не только одними законами и строгими наказаниями.

К счастью, генеративный ИИ — не единственный вид машинного интеллекта. Несмотря на всю его хваленую способность рекомбинировать тексты, изображения и звуки, именно люди создают полезные знания, полученные на реальном опыте, собирают актуальные данные из внешней среды, делают на их основе правильные выводы. Полезные негенеративные ИИ-системы могут не только помогать жуликам, но и следить за ними, выявлять, ловить и обезвреживать.